Zero Density desvela todos los secretos de su demo para IBC 2022

IBC 2022 acogió una demo en directo de realidad aumentada y extendida basada en LED protagonizada por los últimos desarrollos de Zero Density.

La primera parte de la demostración estaba protagonizada por una producción de realidad aumentada fotorrealista. Para alcanzar este nivel de fidelidad de imagen, Zero Density empleó el renderizador de ray tracing y el compositor 3D en tiempo real Reality Engine. Gracias a esta tecnología, los gráficos aumentados se convierten en una parte del entorno físico donde los reflejos de los presentadores y los objetos que rodean a los gráficos pueden verse en sus superficies.

Más allá de la transparencia básica, Reality Engine permite lograr un ray tracing realista de cristales esmerilados. Además, en función del ángulo de la cámara, se pueden apreciar los destellos de la lente en el conjunto, así como un llamativo efecto bloom creado por los reflejos en la superficie metálica.

Más allá de la transparencia básica, Reality Engine permite lograr un ray tracing realista de cristales esmerilados. Además, en función del ángulo de la cámara, se pueden apreciar los destellos de la lente en el conjunto, así como un llamativo efecto bloom creado por los reflejos en la superficie metálica.

En un plató con gráficos de realidad aumentada, conocer la posición exacta de los actores permite crear escenas más interactivas. Al enviar los datos de la posición 3D en tiempo real del actor a Reality Engine, el sistema de seguimiento de actores Traxis talentS, basado en la inteligencia artificial, permite crear gráficos de realidad aumentada que pueden activarse y desactivarse en función de la posición del actor.

Grafismo en videowall

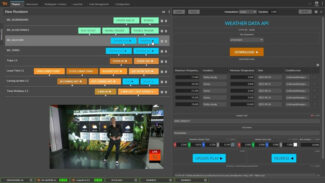

Otra clave de la demo de Zero Density en IBC 2022 fue la aplicación del grafismo en tiempo real en videowalls utilizando RealityHub, solución que proporciona una interfaz de usuario dinámica unificada basada en HTML5 para controlar todo el ecosistema Reality. Estos elementos gráficos pueden rellenarse con un archivo de hoja de cálculo o pueden vincularse con cualquier fuente de datos externa para mostrar datos en tiempo real, sin necesidad de utilizar ningún plugin adicional ni de escribir una sola línea de código.

En la demo se mostraron dos importantes casos de uso de los videowalls: una tabla de previsión meteorológica para cinco días y un gráfico de cambio de divisas en tiempo real. Los gráficos meteorológicos obtienen datos de texto e imágenes de un repositorio de datos externo y se actualizan en tiempo real para cualquier región seleccionada del mundo. Los gráficos de cambio de divisas también utilizan datos en tiempo real.

En la demo se mostraron dos importantes casos de uso de los videowalls: una tabla de previsión meteorológica para cinco días y un gráfico de cambio de divisas en tiempo real. Los gráficos meteorológicos obtienen datos de texto e imágenes de un repositorio de datos externo y se actualizan en tiempo real para cualquier región seleccionada del mundo. Los gráficos de cambio de divisas también utilizan datos en tiempo real.

A la vez que dota a los operadores de herramientas “potentes y fáciles de usar”, RealityHub también ha sido diseñado para cumplir con todos los requisitos de un flujo de trabajo de noticias. La solución es compatible con la mayoría de los sistemas informáticos para salas de redacción (NRCS) disponibles en el mercado a través del protocolo MOS.

Reality Engine es compatible con todas las resoluciones de emisión estándar, como HD y UHD 4K. Pero su adaptabilidad va más allá. En la demostración, el videowall LED se utiliza en su resolución nativa sin comprometer la calidad ni el rendimiento.

Set extendidos

Reality Engine también puede extender y componer conjuntos virtuales más allá del volumen LED. Combinando los mundos físicos y virtuales extendidos, Reality Engine puede transformar espacios físicos pequeños en enormes y dinámicos mundos virtuales en 3D. En la demostración, la pantalla LED física detrás del presentador muestra una extensión del estudio virtual para el entorno de Marte con el presentador en la superficie de Marte. Esto se construye enteramente a través de XR y se facilita a través de Reality Engine. El plató virtual está diseñado por Myreze y lo utiliza The Weather Channel para cubrir el segmento “Misión a Marte”.

A medida que la cámara se desplaza, los ángulos de perspectiva en el videowall cambian en consecuencia, haciendo que las escenas sean más reales. Además, la inclusión de un Mars Rover de la NASA aparcado cerca del presentador crea un entorno 3D envolvente.

Equipo para la demo de Zero Density en IBC 2022

- El sistema de producción contaba con un flujo de trabajo IP de extremo a extremo ST2110.

- La configuración de producción utilizó la cámara de sistema グラスバレー LDX 86N 4K con el objetivo Canon CJ12EX4.3BIASE 4K.

- La LDX86N es rastreada por la grúa Egripment T10 con seguimiento mecánico.

- TRAXIS talentS se utiliza para el seguimiento de talentos.

- RealityHub 1.3 se utiliza para controlar los gráficos en tiempo real.

- El estudio virtual y el escenario AR / XR utilizan Reality 4.27 y son raytraced.

- Para todas las demostraciones se utilizan cinco estaciones de trabajo RealityEngine Ampre con GPU Nvidia RTX A6000 y tarjetas de E/S de vídeo AJA Corvid44 12G.

- Un Reality Engine se utiliza para el estudio virtual, otro para la RA, otro para los gráficos XR basados en LED, otro para alimentar el videowall y otro para los gráficos de emisión al aire.

- Los tres módulos de demostración utilizaron tres estaciones de trabajo RealityEngine Ampre con GPU Nvidia RTX A6000 y tarjetas de E/S de vídeo AJA Corvid44 12G.

¿Te gustó este artículo?

Suscríbete a nuestro RSSフィード Y no te perderás nada.